近日,我校理学院王健副教授与印度统计研究所Nikhil R. Pal (印度科学院院士,IEEE Fellow)教授合作,在神经网络容错学习理论和结构优化研究中取得突破性进展。相关论文《带权值噪音的组稀疏正则神经网络:渐近收敛性及结构修剪策略》(Weight Noise Injection-Based MLPs With Group Lasso Penalty: Asymptotic Convergence and Application to Node Pruning)在国际人工智能领域权威期刊IEEE Transactions on Cybernetics刊发。我校王健副教授为第一作者,Nikhil R. Pal院士为通讯作者,中国石油大学(华东)为第一署名单位。该研究得到国家自然科学基金、山东省自然科学基金和中央高校基本科研业务基金资助。

神经网络是对人脑神经系统的一个简单模拟,由于其具有分布式存储、并行计算及良好的处理非线性问题的能力而得到广泛研究。利用神经网络进行动态系统的容错控制是现代容错控制技术的重要组成部分,已成功应用于诸多工程领域。现有研究主要考虑加入L2正则子权值衰减项,进行容错学习算法改进、目标函数设计及渐近收敛性分析等。但由于L2正则子自身性质的特点,决定了此类算法不易产生稀疏解,在处理变量选择、特征提取和结构优化等问题时不可避免地处于劣势,限制了神经网络学习算法的应用广度。

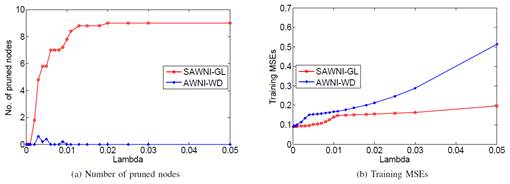

针对上述难题,王健团队从网络模型设计角度出发,在训练过程中考虑加性噪音和乘性噪音的同时加入Group Lasso正则项,实验结果表明该容错学习算法对这两种典型噪音都有很强的鲁棒性。对比L2正则子,Group Lasso正则子具有更易产生稀疏解的优势,但其非凸、非光滑的函数特性容易导致训练过程中产生振荡现象,该团队借助函数光滑逼近的思想有效避免了奇点问题,并严格证明了学习模型的渐近收敛性结论,保证了设计算法的合理性,为容错学习结构优化模型的设计提供技术支持和理论指导。

审稿专家对该研究工作给予高度评价,认为该成果在容错学习模型设计方面具有较好的应用推广价值,尤其在深度学习构造最简网络结构具有很强的指导作用。

IEEE Transactions on Cybernetics创刊于1960年,在自动化与控制系统、人工智能和控制论领域具有很高的影响力,对研究内容的创新性、前沿性要求非常严格,最新影响因子为10.387,属于SCI一区TOP期刊,是控制论与人工智能域的顶级期刊之一。

王健副教授、博士生导师,主要开展计算智能、机器学习等领域研究。现担任跨媒体大数据联合实验室主任,山东省数学会理事,Journal of Applied Computer Science Methods和IEEE Transactions on Neural Networks and learning Systems(SCI一区,影响因子:11.683)副主编。

Nikhil R. Pal 教授,长期从事模糊系统、神经网络、认知科学等领域研究工作。现为印度工程院院士、印度科学院院士、IEEE Fellow、国际计算智能协会主席,担任IEEE Transactions on Cybernetics、Fuzzy Sets and Systems、International Journal of Neural Systems等多个国际学术期刊副主编,于2018年11月受聘我校荣誉教授。

全文链接:https://ieeexplore.ieee.org/document/8561200?denied=

(理学院 谢雪涛)